- tags:: PromptPerfect

功能模块

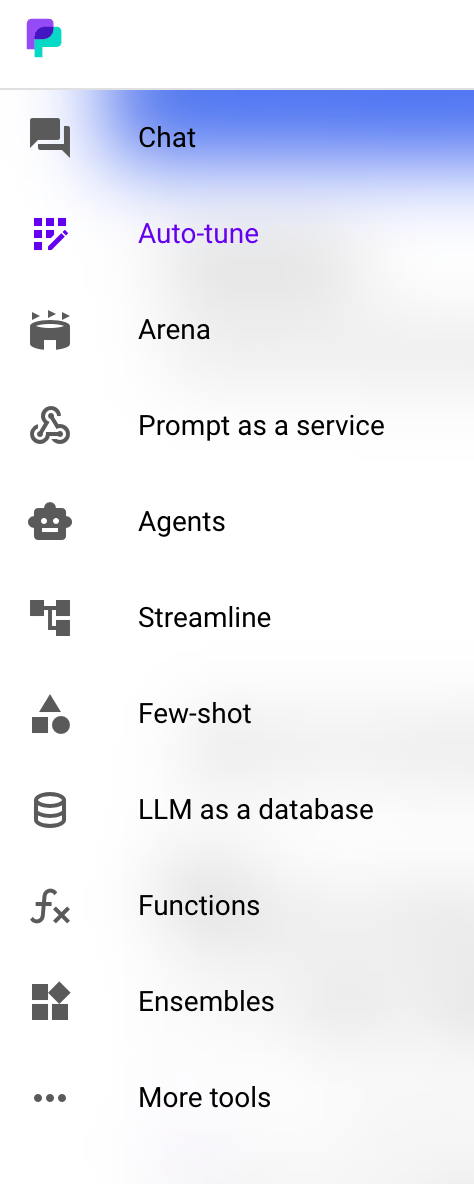

侧边菜单

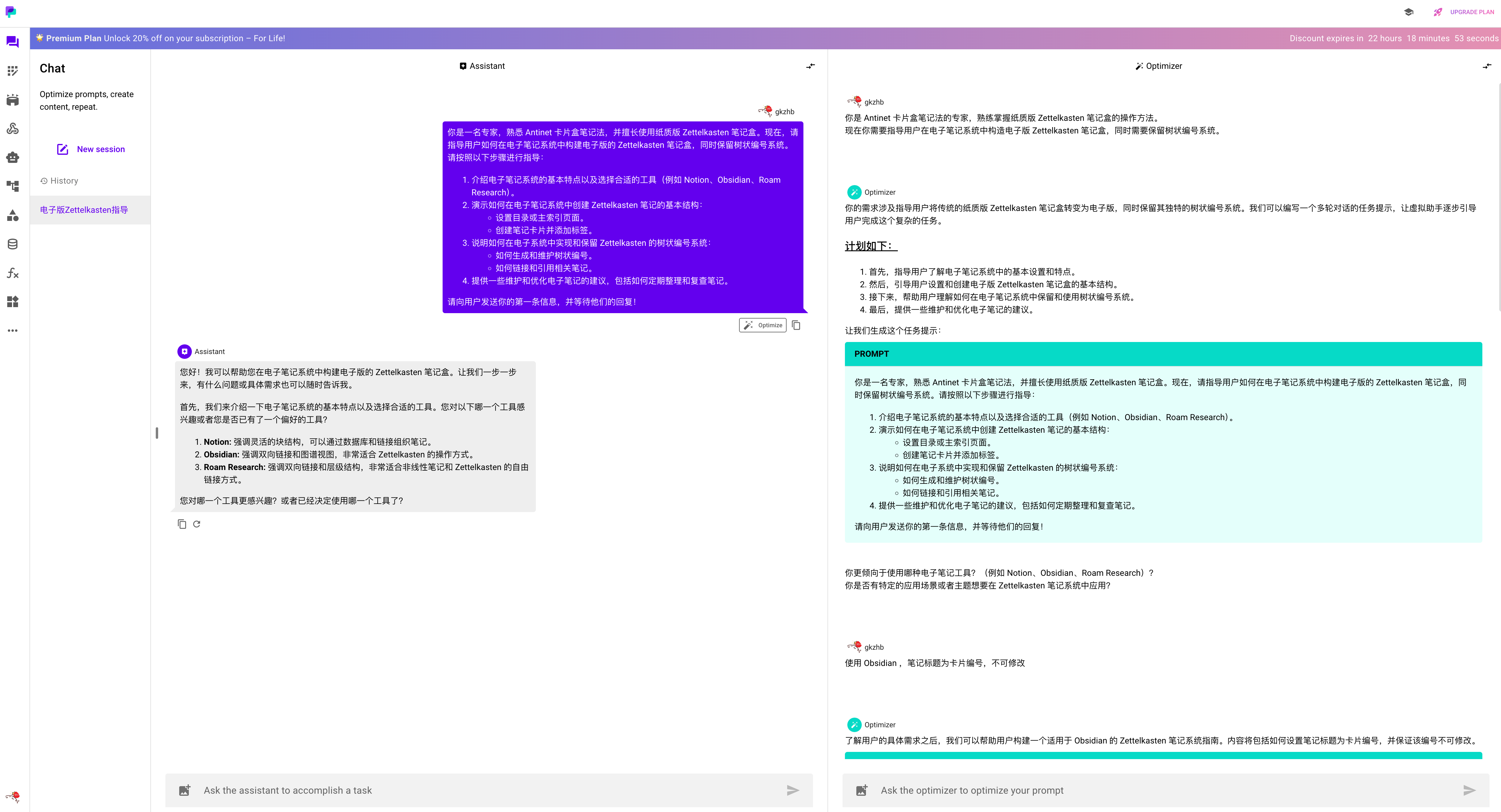

Chat

Chat 模块分为两部分,一侧(对话侧)是模拟真实使用场景和 LLM 对话,另一侧(优化侧)是对话交互来优化 LLM 提示词。

通过优化侧的对话,会不断细化提示词的内容细节及内容的方向。

优化提示词的效果体验下来不是很好。

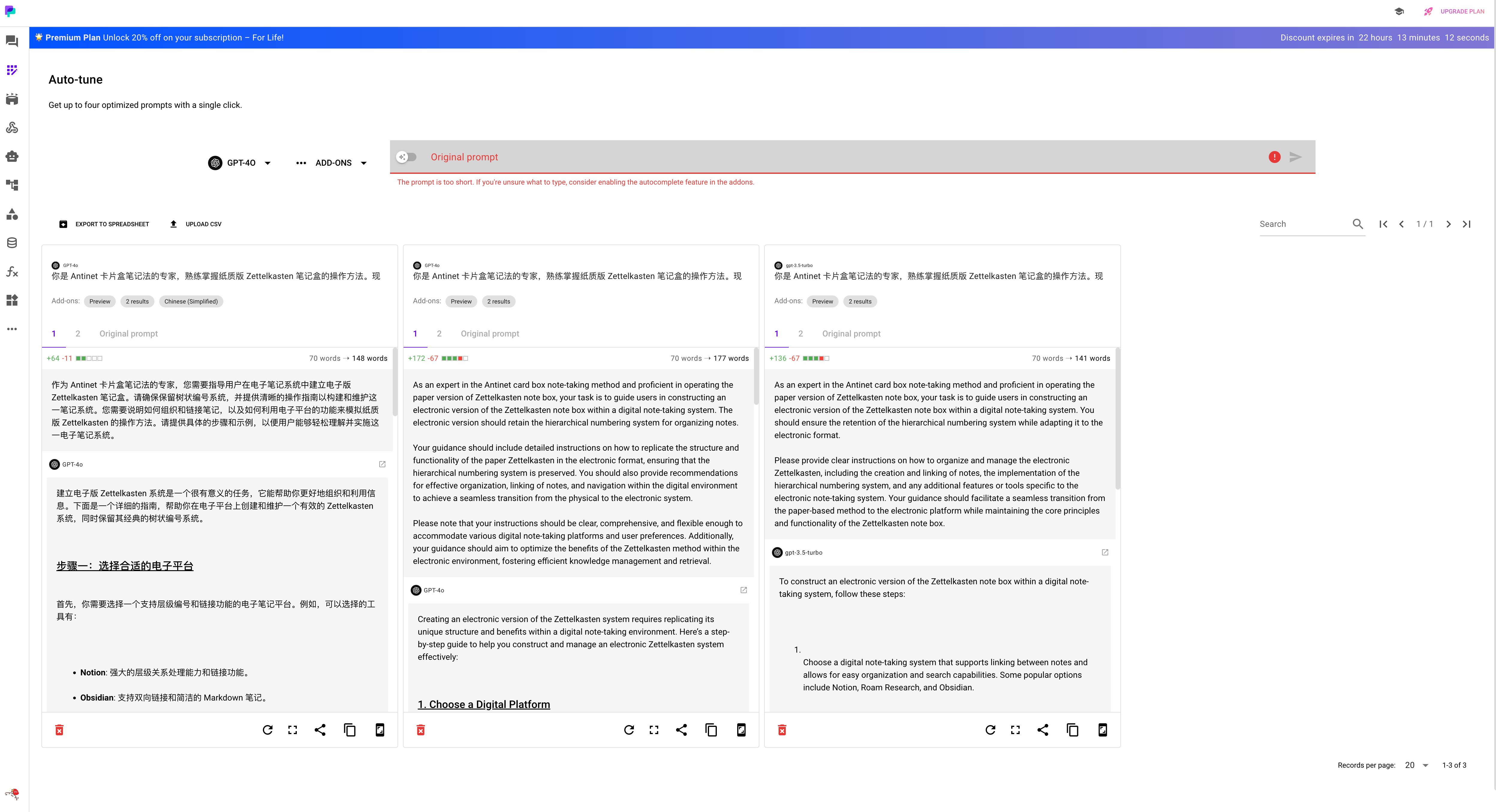

Auto-tune

直接优化提示词,提供 2 个优化后的版本,每个版本及原始提示词展示 LLM 回答效果

Diversify optimization: Multiple algorithms will be applied to the original prompt to generate diverse and optimized prompts.

核心产品逻辑就是一个这个描述

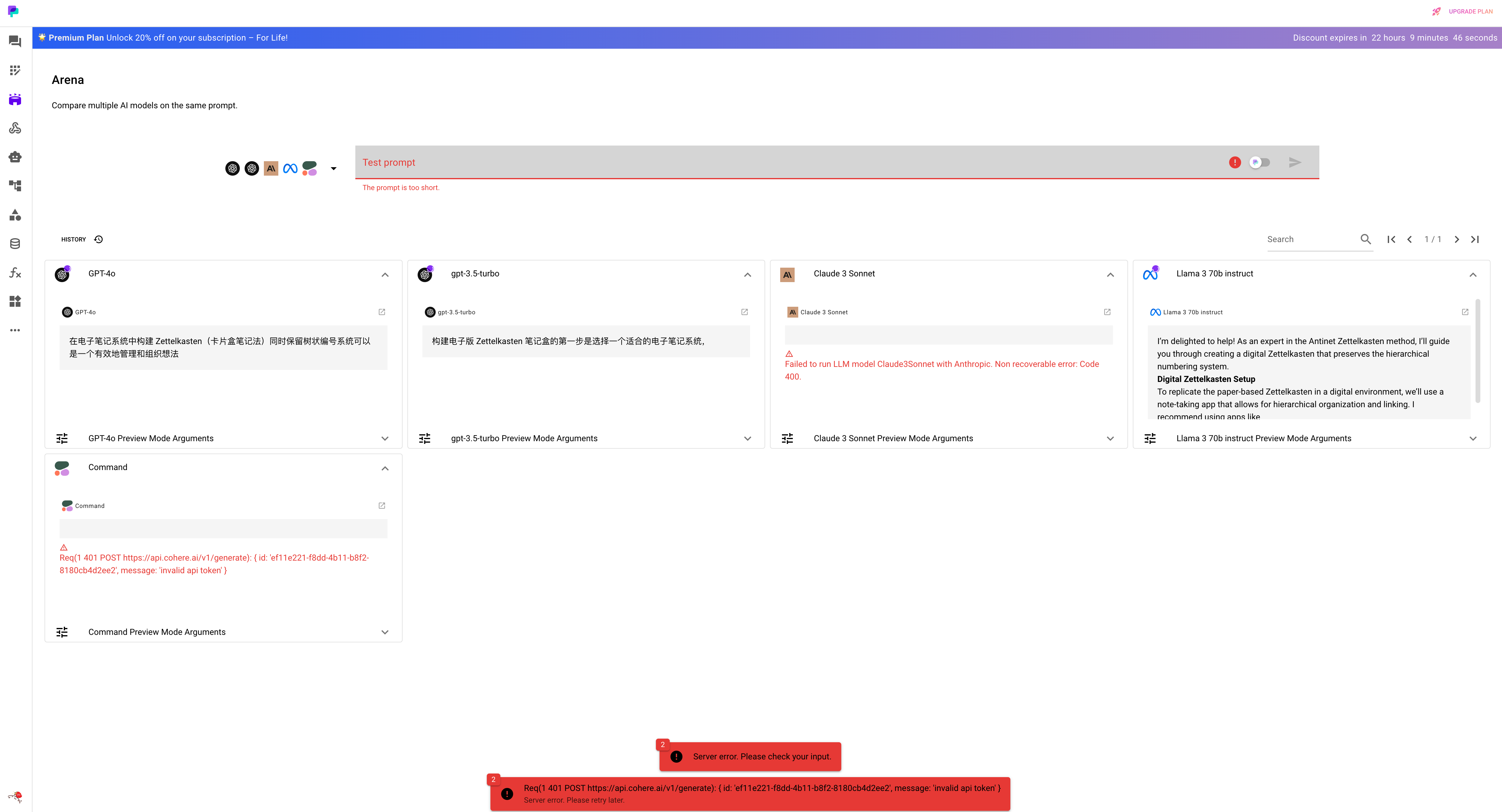

Arena

使用一个提示词问不同模型,对比不同模型的回答效果

Prompt as a service

直接看如何调用接口:

curl "https://api.promptperfect.jina.ai/xxxxxxxx" \

-H "x-api-key: token $YOUR_GENERATED_SECRET" \

-H "content-type: application/json" \

--data '{"parameters": {"characterA":"YOUR_VALUE","characterB":"YOUR_VALUE"}}'

传入提示词模板中的变量的内容,接口返回模型回答结果。

后端服务可以收集调用接口的数据,用于后续提示词优化。

没什么新意或特色。

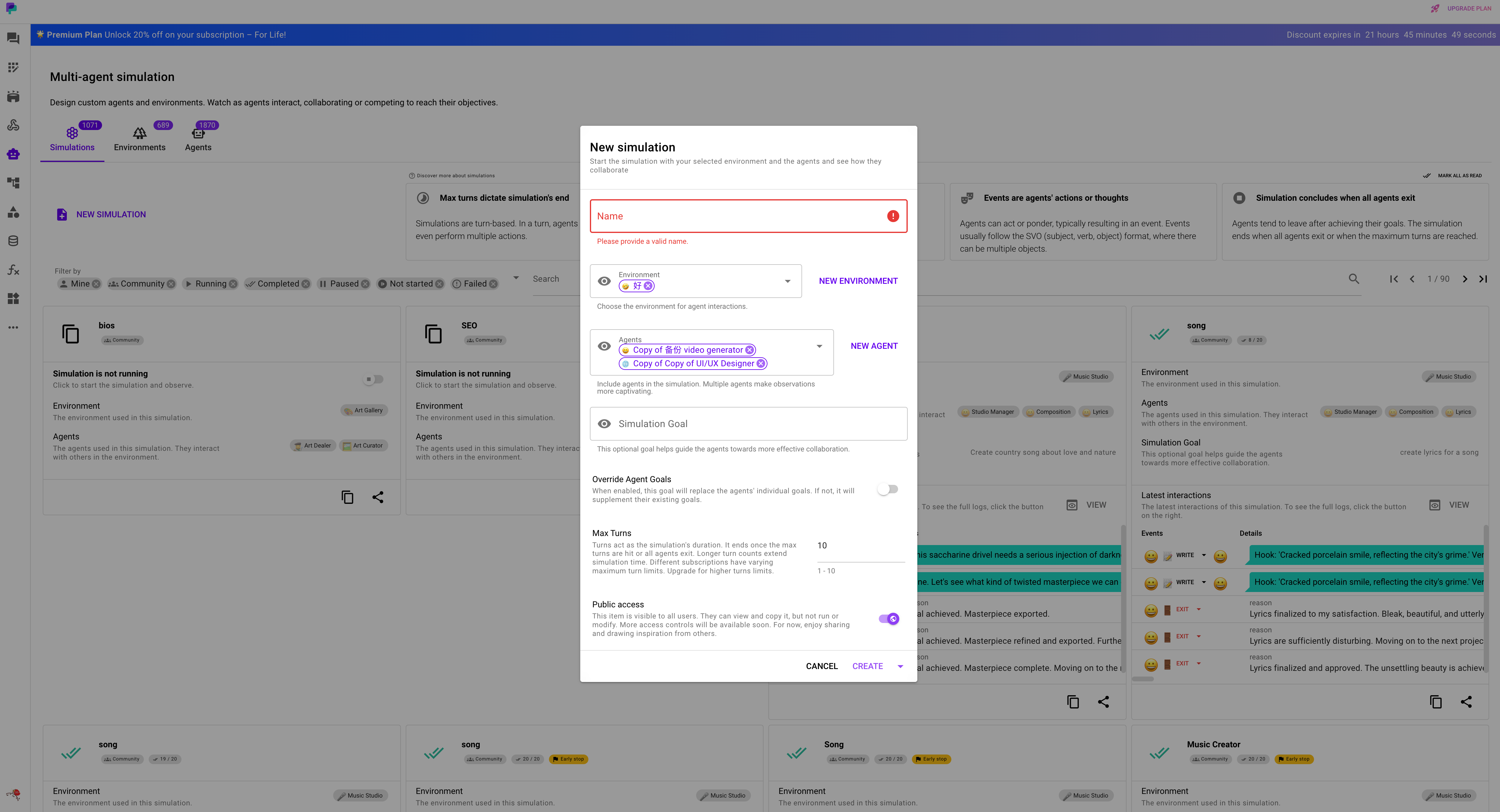

Agents

看 simulation 创建表单可以明白产品逻辑: 单独创建环境和 agents 后,在 simulation 中组装环境和 agents 就可以让 agents 在环境中自主执行,并观察执行结果。

环境只有纯文本描述。

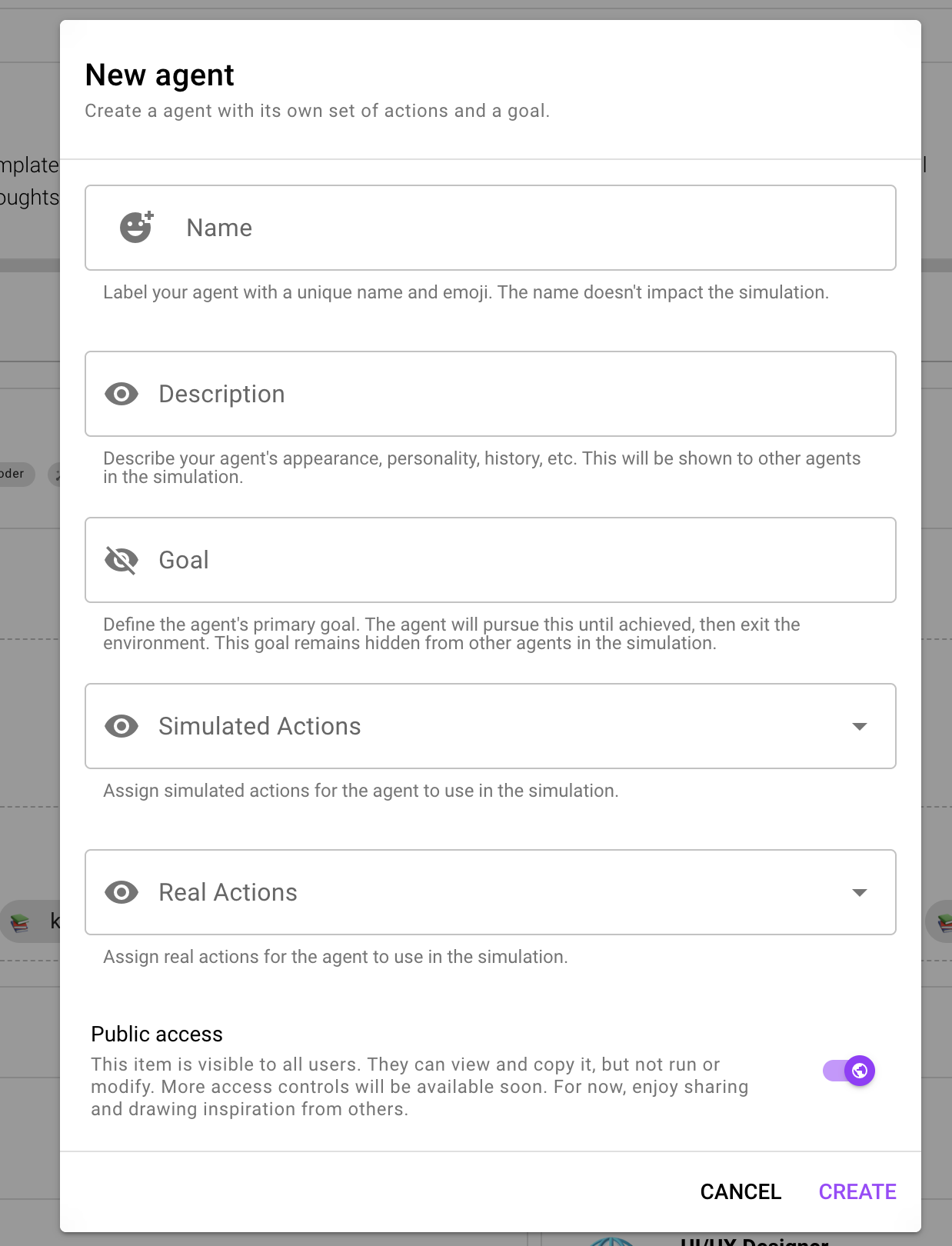

创建 agent 有以上属性,模拟行为列举了人的各种行为,比如观察、调研、训练、说话

真实行为提供真实的工具调用数据,比如 Google 搜索

agent 执行顺序如何确定的?

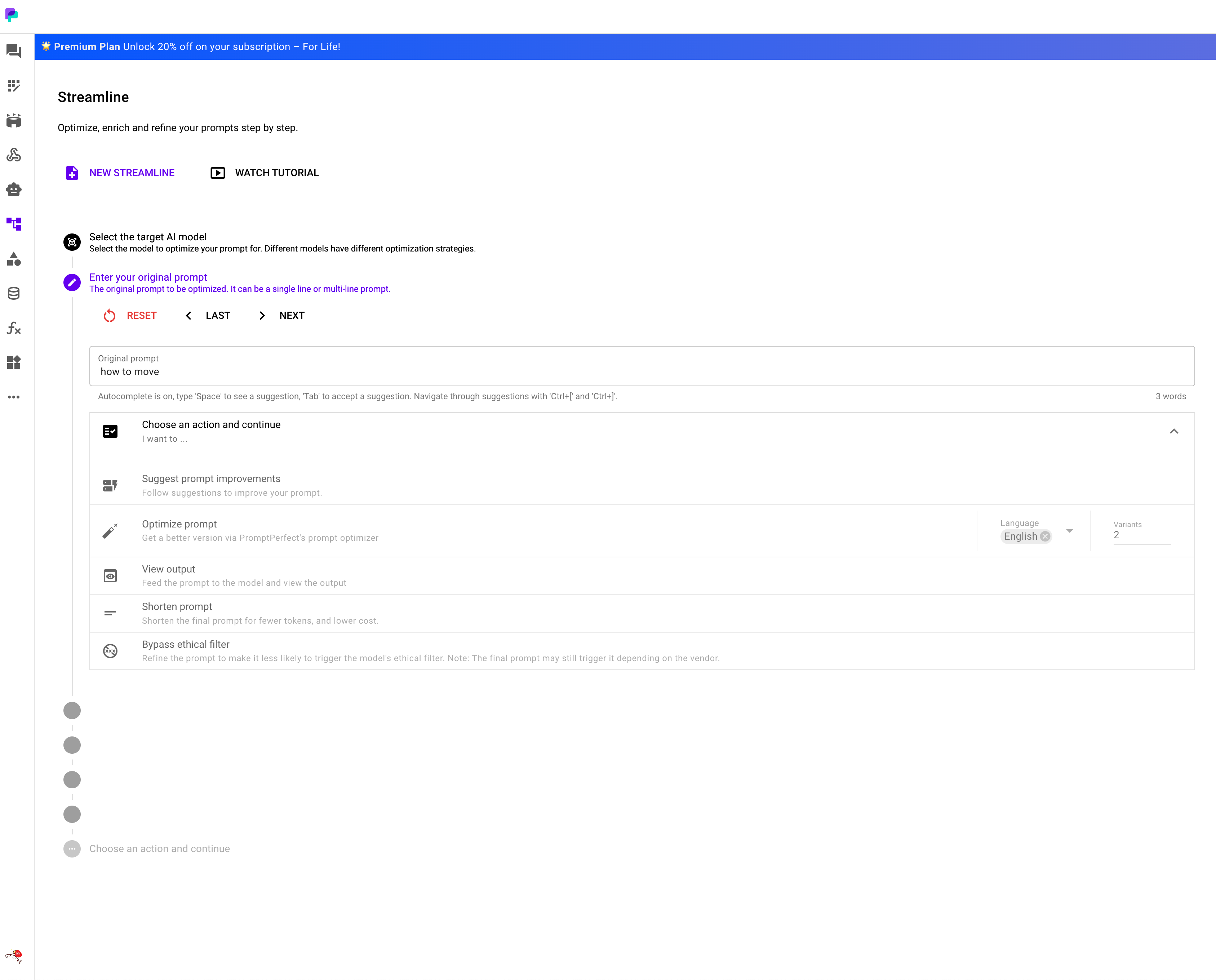

Streamline

看不懂是干什么,可能是自定义流水线操作管线,然后自动化按照管线执行来优化提示词。

界面交互看起来像是有 bug…

Few-shot

参考提示词工程的概念,将 few-shot 方法做成一个页面功能,用户填入指令、demo 示例、目标任务这三部分,页面帮你拼成一个完整的提示词。

还有针对示例部分做了一些逻辑操作,比如随机取 3 条示例到提示词中。

LLM as a database

通过给 LLM 提供 QA 问答对的数据,将 LLM 作为一个数据库提取信息。

支持提示词中注入一些动态的信息,比如当前时间日期

Functions 工具调用

调试在工具调用场景 LLM 会如何回答。

包括工具调用参数及根据工具调用结果 LLM 会如何回复。

Ensembles 融合模型

将相同提示词输入给不同模型,将所有模型结果聚合后让 LLM 融合结果,获得最终模型输出。

从使用方来看这个过程就相当于调用一个 LLM

产品特点

多语言支持

支持配置让 LLM 生成特定语言的回答

用户引导

每个模块一般都会提供几条 demo 数据

在 Chat 模块提供了 mask + popover 方式的用户引导

在 Auto-tune 模块,提供了功能体验进度提示的引导

前端交互

前端交互很简单,很多地方 UI 很奇怪,给人一种半成品的感觉,缺少精细打磨的感觉